基礎知識

ChatGPTによって機密情報を漏洩するリスクと対策方法を解説

ChatGPTの利用を検討している方の中には、ChatGPTによる機密情報の漏洩リスクを懸念されている方もいるのではないでしょうか。また、ChatGPTの利用時に情報漏洩を避けるための対策方法を調査している方もいると思います。

当記事では、ChatGPTの活用によって機密情報の漏洩に繋がるリスクと情報漏洩を避けるための対策方法を解説します。

ChatGPTによって機密情報を漏洩するリスク

ChatGPTの利用によって機密情報の漏洩に繋がるリスクが2つあります。

【機密情報を漏洩するリスク】

- 入力したデータが他の利用者の回答として出力される

- ChatGPTのセキュリティ上の問題によって情報漏洩になる

入力したデータが他の利用者の回答として出力される

ChatGPTに入力した内容は、AIの学習データとして利用されるため、他の利用者の回答として出力されて機密情報が漏洩してしまう可能性があります。

実際、韓国の大手電子機器メーカーでは、社員が機密情報を入力して情報を漏洩した可能性があるとして、ChatGPTなどの利用を制限しています。

また、ChatGPTを特定の手法で教育を行うことで保存されたデータが出力されてしまう事例が、AIの専門家による研究によって確認されています。なお、この事例はOpenAI社に共有されており、すでに対策済みのため、この手法によって情報が漏洩することはありません。

ChatGPTのセキュリティ上の問題によって情報漏洩になる

ChatGPTを利用する際は、セキュリティ上の問題やサイバー攻撃による情報漏洩のリスクがともないます。こういった問題はChatGPTに限らず、インターネット上のサービス全般に言えることですが、外部サービスの利用による情報漏洩リスクの1つです。

過去の事例として、ChatGPTの有料アカウント情報が不正に取得され、違法サイトに公開される事態が発生しました。このようなアカウントの不正利用が発生すると、利用者がChatGPTに入力したチャット履歴が第三者によって閲覧され、機密情報が漏洩する可能性があります。

ChatGPTを利用する企業が情報漏洩を避けるための対策

ChatGPTの利用をする場合は、機密情報の漏洩を避けるための対策を実施しましょう。

【情報漏洩を避けるための対策】

- 社内ガイドラインを作成する

- 入力内容を学習データに利用されないようにする

社内ガイドラインを作成する

企業や複数人のチームでChatGPTを利用する場合は、機密情報の取扱いについてのガイドラインを作成してメンバーと共有しましょう。

作成する社内ガイドラインには、どのような情報をChatGPTに入力してよいのか、どのような用途で利用すべきか、機密情報を保護するための具体的な手順などを含めるようにしましょう。

【ガイドラインの作成ポイント】

| ポイント | 詳細 |

| 機密情報の定義 | 企業が機密とみなす情報の種類を明確に定義する |

| 利用目的の限定 | ChatGPTの利用可能な業務や目的を具体的に定める |

| 入力情報の制限 | 機密情報を含む可能性がある情報の入力を禁止するルールを設ける |

| セキュリティ対策の強化 | 安全なパスワードポリシーの策定などを行う |

ただし、ChatGPTの利用ガイドラインを設定している会社の社員が機密情報を入力してしまった事例もあります。そのため、ガイドライン作成後は、社内に波及させるための社内研修や定期的なリマインドを行うようにしましょう。

入力内容を学習データに利用されないようにする

ChatGPTに入力したデータをAIの学習データに利用されないようにすることで、入力した情報が他の利用者の回答に使用されなくなります。

【AIの学習データに利用されないようにする方法】

- 入力内容を学習データとして利用させないための設定をする

- 入力した情報が学習に利用されないプランを利用する

- ChatGPT APIを利用する

入力内容を学習データとして利用させないための設定をする

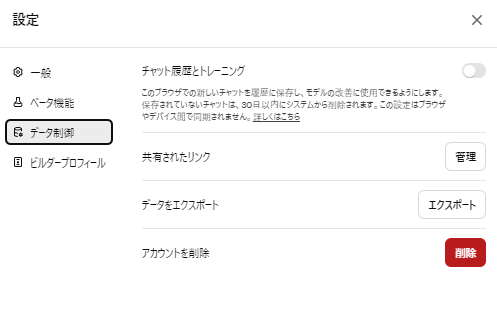

ChatGPTの利用者は、自身の入力内容がAIモデルの学習データに含まれないように設定(オプトアウト)することができます。この設定は、ChatGPTの「設定」を選択し「データ制御」にある「チャット履歴とトレーニング」をオフにすることで完了します。

【チャット履歴とトレーニングの設定画面】

「チャット履歴とトレーニング」をオフにすると、入力されたデータが将来のモデルのトレーニングに使用されることがなくなります。

しかし、「チャット履歴とトレーニング」をオフにした場合、チャット履歴の保持期間が30日間に短縮されてしまいます。そのため、ChatGPTのチャット記録を長期間保存したい方は、この点を特に注意する必要があります。

入力した情報が学習に利用されないプランを利用する

ChatGPT EnterpriseやChatGPT Teamなどの有料プランでは、入力した情報が学習データのトレーニングに利用されません。また、管理コンソールによって、チームメンバーの権限や利用できる機能の管理が可能です。

【セキュリティ面の特徴】

| プラン名 | 特徴 |

| ChatGPT Team |

|

| ChatGPT Enterprise |

|

また、ChatGPT TeamsやChatGPT Enterpriseは、セキュリティ向上のほかに、GPT4への高速アクセスやメッセージ回数の引き上げなどもされます。

ChatGPT APIを利用する

ChatGPT APIの利用は、企業が機密情報を保護しながら、ChatGPTの機能を自社のシステムやサービスに統合するために使うことができる方法です。

API(Application Programming Interface)を利用することで、自社で利用するアプリケーションからChatGPTの機能を呼び出し、問い合わせ処理やデータ分析などを行うことが可能になります。

ChatGPT APIを通じて行われるやり取りは、OpenAIのモデル学習データに含まれません。そのため、機密情報の漏洩リスクが軽減されます。

ただし、ChatGPT APIの利用には、プログラミングの知識が必要です。APIを企業のシステムに統合するためには、開発者がAPIの仕様を理解し、適切なコーディングを行う必要があります。

また、APIを通じてChatGPTを利用する際には、APIの呼び出し回数や利用量に応じた費用が発生するため注意が必要です。ChatGPT APIの料金についてはOpenAIの公式サイトをご確認ください。

企業向けのAIサービスを活用する

ChatGPTなどの生成AIを情報漏洩のリスクを軽減しつつ、業務に活用する手段として企業向けのAIサービスを活用する方法があります。企業向けAIサービスは、機密情報の保護、セキュリティの強化、法規制の遵守など、ビジネス環境での使用に特化した機能とサポートを提供します。

JAPNA AI株式会社の提供する 「JAPAN AI CHAT」 は、ChatGPTの機能を備えた多機能AIツールで、アプリケーションのヘルスチェックやアラート機能により機密情報を守る体制を整えています。

また、導入企業を対象に、AIの利用支援やAI研修を実施することで、企業が安全にAIツールを活用できるように支援しています。そのため、AIツールの使用に関するノウハウを持っていない企業でも安心して利用することが可能です。

まとめ

ChatGPTの活用は、企業の業務効率化をもたらす一方で、機密情報の漏洩というリスクもあります。情報漏洩のリスクとしては、入力したデータが他の利用者の回答として出力される可能性や、セキュリティ上の問題による情報漏洩があります。

ChatGPTを業務で利用する企業が情報漏洩のリスクを軽減するための対策には「学習データとして利用されない設定の利用」「法人向けプランの利用」「社内ガイドラインの作成」「ChatGPT APIの利用」などがあります。

ChatGPTを業務で利用を検討している企業は、これらの対策から自社に適したものを選択して情報漏洩のリスクの対策を行うようにしましょう。

AIを活用した業務工数の削減 個社向けの開発対応が可能

事業に沿った自社専用AIを搭載できる「JAPAN AI CHAT」で業務効率化!

資料では「JAPAN AI CHAT」の特徴や他にはない機能をご紹介しています。具体的なAIの活用事例や各種業務での利用シーンなどもまとめて掲載。

あわせて読みたい記事